エコノミスト誌(6/4号;使える統計学)を統計学的に考察する。

ここまで、長い間、Hadoop MapReduce をつかうためのシステムの準備と試行を行ってきた。

一連のブログのテーマは「ビッグデータ」を軸に据えているので、これだけでは片手落ちである。

今回は、2013/6/4 号のエコノミスト誌「使える統計学」について、少し突っ込んで考察してみる。

データの表現形式とビッグデータ

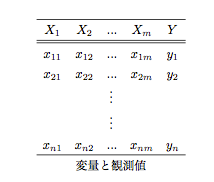

まず、データは、X とY の記号を用いて、以下のような表で表す。

変量はm+1 個で、そのうちのm 個をX、1つをY とする。X とY に分けたのは、エコノミスト誌で用いられた手法が重回帰分析であったからで、この場合景気動向指数CI がY、説明変数の候補がXに該当する。

ここで、各行はサンプルを表すが、観測値は小文字のx,y で表し、n をサンプリングサイズとする。

ビッグデータとは、「このm とn が極めて大きい(典型的にはn が極めて大きい)データ」のことを意味すると考えればよい。

エコノミスト誌によると、

- 2010/4 から2012/12 のつぶやきから5% の無作為抽出データを使った

- この結果より、CI との相関の高い300 キーワードを選択した。これらには、出現回数が2000 回以上などの条件をつけた。

言い換えると、これは、

- 2010/4 から2012/12 の「つぶやき」からランダムに5% のつぶやきを取り出し、サンプルの決定、サンプリングサイズ(n)を決定した。

- X の決定には、Y(CI)との相関を測定して、相関が高い(と考える)300 語を選択した(m=300)。

ということを意味している。

そして、

- 2008/1 から2012/3 の全データから出現回数をカウント、そのデータをもとに重回帰分析の複数の手法を試し、数万個の予測式の候補を作成した。

- 予測式は、数十程度の言葉についてそれぞれ、1 ヶ月あたりの出現率に、定数をかけた総和で表される。

とある。これを言い換えると、

- 2008/1 から2012/3 の全データから月別の出現率(300 語にある言葉が出現したTweet/全Tweet)を算出した。

- 300 語から作成した予測式は、数十項目の説明変数から成り立っている。

ということを意味している。

300 個の説明変数から、重回帰分析の変数(X)を選択しているので、単純計算しても、300 個から2 つを選択するだけでも、

の組み合わせが存在して、10000 のオーダーに乗ってしまうので「数万個の予測式」というオーダーは、m=300 では驚く数字ではない。

Tweet というある意味「(CI と)なんの関係もなさそうな」説明変数を選んでいる(これが「ビッグデータ」っぽい)ため、最もCI との相関が高い語句を選択しても、1つの言葉の説明能力が極めて低い(CI への寄与が低い)を想定される。CI との相関をみながら、相関の高い順に並べることを基本として、数十個に固めていったのではないかと推測する。

また、重回帰分析の手法も、線形回帰、数量化1類などの手法が存在するし、CI やX(語句の出現頻度)を特定の関数で変換することも考えられるが、これらについての記載はない。

CI が月次で発表されるため、1ヶ月を集計期間として選んだと推測する。CI のデータは内閣府のページからCSV 形式で取得できるが、4 月のCI 値が6/20 に発表されており、集計期間と発表には1 ヶ月以上のタイムラグがある。なお、記事には、1 ヶ月をどのように定義したのかについての記載はない。

「1ヶ月を集計期間とした語句の出現頻度」を説明変数とした回帰分析を行うとした場合、n は51 個(2008/1 から2012/3 の51 ヶ月)となり、サンプリングサイズとしては大きいものではない。(ただし、生データであるTweetsは巨大である)

従来、回帰モデルを含む経済指標の分析は、計量経済学(Econometrics)と言われて非常に長い歴史がある。

パンチカードの時代から、経済学者によって研究されてきた分野である。

とすると、このTweet 分析の「なにが新しいの?」ということになるが、

- 政府や調査会社による調査結果に基づいていないということ。

- WebやSNSに基づいた推測ができることによって、予測にかかる期間の劇的な削減が可能になるかもしれないこと(すでに他の分野では、GoogleやYahoo!によって実現されている)。

- Tweet からCI を説明しようという試みが、これまで「ありえなかったほどAdhoc (Heuristicといった方が適切かも)な分析」であること。

- Tweet のオーダーが(推測するに)数億というオーダーになっているであろうこと(ただし、上記のように5% のランダムサンプリングを行っている)。Tweet から取得した本文から抽出した(意味のありそうな)語句は、Tweet の10 倍から数十倍になっているはずで、これらを処理することは技術的なブレークスルーであること。

ということになろうかと思う。

データが「みんなのもの」になったという意味で革命的な出来事であって、今後もこの傾向に拍車がかかっていく。

ビッグデータ解析(発見的手法としての新しさと、データ処理としての新しさ)は、近い未来に「あたりまえのこと」になるのは、事実だと思う。